摘要:阐述了人机交互与人工智能的关系,介绍了人机融合智能的探索方法,即把人与机器有机融合在一起;分析了智能人机交互目前的标准进展;最后分析人机交互未来发展的重点方向是感知交互和急需解决的伦理问题。

关键词:人工智能; 人机交互; 人机融合智能;

Research on Standardization of Human-computer Interaction Technology in the Era of Artificial Intelligence

Abstract:This paper explains the relationship between human-computer interaction and artificial intelligence,introduces the exploration method of human-computer fusion intelligence,that is,man and machine are organically integrated;Analyzes the current standardization progress of artificial human-computer interaction;Finally analyzes the future development direction of human-computer interaction is perception interaction and ethical issues that need to be solved urgently.

1 引言

在人工智能时代,随着计算机、手机以及更多嵌入式系统如家电设备、可穿戴设备、机器人等的出现,使研究人机之间的信息交换具有重要意义。然而智能时代下应用场景的变化导致新的需求,如交互方式不自然、效率不高等,对人机交互提出了巨大的挑战。如何应对瞬息万变的态势,实现相对智能化的深度态势感知,以辅助人类实时、高效、科学的进行决策,已成为人机交互需要研究的关键问题。

2 人机交互与人工智能的关系

人工智能研究的主要目标是使机器能够胜任一些通常需要人类智能才能完成的复杂工作。人机交互本质是人机共在,主要研究人和计算机之间的信息交换。人工智能和人机交互是相辅相成、相互促进的关系。

人工智能驱动了人机交互技术的发展和变革。在人类输入方式上,从五笔到拼音到语音,从键盘到鼠标到触屏,人机交互方式越来越人性化,但不是很高效自然。通过语音识别、图像识别等人工智能技术,人类不用被迫去适应机器,出现了语音、手势、情感等交互方式,人类可以用更自然的方式与机器进行交互。

人机交互为人工智能提供了应用需求和研究思路。人机交互首先应发展的是人机对话,当前的智能产品如苹果的Siri、微软的小冰、亚马逊的Echo等都使人机对话方式更高效自然,可以说人机对话的需求推动了人工智能的发展。

3 人机融合智能

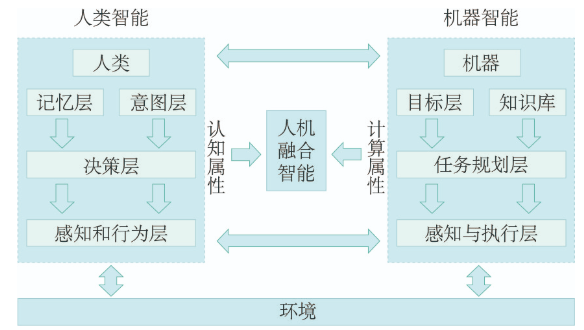

人工智能技术发展到一定程度,为满足更多需求,人类开始研究人机融合智能,它既包括人工智能的技术研究,也包括机器与人、机器与环境及人、机、环境之间关系的探索。人机融合智能是目前发展重点,人机融合智能是由人、机、环境系统相互作用而产生的新型智能系统,图1是人机融合智能的原理。它与人的智慧、人工智能不同,具体表现在三个方面:首先是智能输入端,它是把设备传感器客观采集的数据与人主观感知到的信息结合起来,形成一种新的输入方式;其次是智能的数据/信息中间处理过程,机器数据计算与人的信息认知融合起来,构建起一种独特的理解途径;最后是智能输出端,它把机器运算结果与人的价值决策相互匹配,形成概率化与规则化有机协调的优化判断。人机融合智能也是一种群体智能形式,不仅包括个人还包括众人,不但包括机器装备还涉及机制机理,关联自然和社会环境、真实和虚拟环境等。

图1 人机融合智能的原理

人机融合智能需要界定角色和责任,以及制定人机协作的规则,这种功能分配的根源在于如何把人类的需求、功能及策略转换成机器感知、能力和执行,即如何把人的感知/理解/预测/反馈与机器的输入/处理/输出/迭代有机地融合在一起。

4 智能人机交互标准化进展

人机交互与人工智能的关系从过去的此起彼伏逐渐变成了当下的相互促进,以图形用户界面、鼠标键盘为主的实物用户界面和手机、平板电脑、透明触屏为主的触控用户界面等人机交互方式很难使人 、机、环境实现高效自然的交互。近年来,随着人脸识别、声纹识别、语音识别、手势识别、姿态识别、情感识别等人工智能技术的进步,智能算法与人机交互出现了互相融合的趋势。目前在笔/手势、语音视觉、情感计算等单一通道人机交互领域出现了一些非常重要的标准。

笔/手势交互是人机交互领域重要的研究方向,而将人工智能方法引入笔/手势交互,可以实现更智能、更自然的交互效果。国内外企业如Google、Microsoft、Intel、Apple、联想、华为等均对手势交互方法进行大量研发,已推出使用触摸手势、笔手势、空中手势的手机、个人平板、交互桌面、交互平板、游戏设备等多尺度、多形态的电子产品。虽然手势交互目前暂未形成主流,但依旧是未来看好的自然交互方式之一。在信息技术领域,手势交互的国际、国内标准匮乏,针对手势交互的分类、识别并无相应标准。目前,由中国电子技术化标准研究院和中国科学院软件研究所等10余家单位起草,通过全国信标委计算机图形图像处理及环境数据表示分技术委员会(SAC/TC28/SC24)已发布GB/T 38665.1-2020《信息技术 手势交互系统 第1部分:通用技术要求》和GB/T 38665.2-2020《信息技术 手势交互系统 第2部分:系统外部接口》2项标准,规范了手势交互系统的框架范围、功能要求、性能要求以及输入/输出接口形式和数据格式。手势交互标准的推广应用,有助于不同操作系统、数据获取终端和识别框架下的手势交互应用开发,适用于不同手势交互系统之间的信息交换,对国内外的手势人机交互软件技术的发展和相关产品提供参考。

语音交互涉及声学、语言学、数字信号处理、计算机科学等多个学科,其交互技术主要包括语音合成、语音识别、自然语言理解和语音评测技术四个方面。目前,ISO/IEC JTC1/SC35用户界面分委会2016年已发布ISO/IEC 30122-1《信息技术 语音命令》系列标准,重点关注语音交互系统框架、规则、构建、测试和语音命令注册管理等。美国从20世纪90年代中期,由美国国家技术与标准研究所(NIST)开始组织语音识别/合成系统性能评测领域相关标准的制定工作。重点关注语音识别/合成词错误率评价、语言模型复杂度计算、训练、合成语音自然度评价和测试语料的选取等。我国智能语音标准主要由全国信息技术标准化技术委员会用户界面分委会(简称用户界面分委会SAC/TC28/SC35)负责研究并制定,涉及数据交换格式、系统架构、接口、系统分类、测评及数据库,以及多场景应用等方面共13项国家标准和行业标准。2019年8月,由中国电子技术标准化研究院、中科院自动化所等单位联合代表我国向ISO/IEC JTC1/SC35提交国际提案ISO/IEC 24661《信息技术 用户界面全双工语音》,并于2019年12月通过NP投票并已正式立项,这也是我国第一个语音交互领域的国际提案。

情感认知计算是自然人机交互中的一个重要方面,赋予信息系统情感智能,使计算机能够“察言观色”,将提高计算机系统与用户之间的协同工作效率。而情感的感知和理解离不开人工智能方法的支撑[1]。2017年2月,由中国电子技术化标准研究院、中国科学院软件研究所等单位联合向ISO/IECJTC1/SC35提交的国际提案ISO/IEC 301150-1《信息技术 情感计算用户界面框架》正式立项,目前该标准已进入FDIS阶段。该标准不仅是用户界面分委会首个关于情感计算的标准,也是我国牵头的人机交互领域首个国际标准,也是用户界面分委会首个关于情感计算的标准。2019年,我国又同时提交3项情感计算国际提案,并成功在2019年7月上海召开的ISO/IEC JTC1/SC35全会和工作组会议上,推动成立情感计算工作组,由中科院软件所王宏安教授任召集人,中国电子技术标准化研究院徐洋担任秘书。同时,国家标准计划《人工智能 情感计算用户界面 框架》(计划编号:20190836-T-469)于2019年正式下达,目前在用户界面分委会开展研制工作,2020年底已完成报批。该系列标准的编制和发布将推动人机交互更加人性化、智能化。

5 人机交互未来发展方向

人机交互发展的总体趋势是以人为中心实现高效自然的交互。从交互界面形态来看,人机交互界面正在从图形用户界面向多通道用户界面和混合用户界面等更为人性化的交互界面发展;从交互技术来看,人机交互正在向脑、心、肌肉等生理计算方面发展;从研究层面来看,人机交互正在使人、机和社会管理活动更紧密结合。因此,未来感知交互是人机交互发展的重点,计算机将感知人的现象、自然现象、人类行为等,实现真正意义上的人机融合智能,从而实现为人类服务。同时人机融合智能及其深度态势感知在发展过程中会面临人机认知不一致问题,进而会导致人机融合后的责任归属问题,因此道德伦理将是未来研究重点。

6 结语

人机融合智能领域的发展离不开长期的技术积累,重点是要依靠数据、算法、硬件等基础支撑层面的技术突破和人机交互、工效学等技术的有机磨合。目前虽然出现了人机融合智能军事应用热潮,在自主系统、ISR、辅助决策、人机协同领域出现了不少新的技术应用,但人机融合智能技术本身仍属于较弱功能范畴,技术进展不大。但是从长远来看,人机融合智能在更多技术瓶颈不断突破中,一定会发展得越来越好。

参考文献

[1]范向民,范俊君,田丰,等.人机交互与人工智能:从交替浮沉到协同共进[J].中国科学:信息科学,2019,12(3):361-368.